Cred că există tool-uri pentru scraping, dar n-aș zice că s-a axat cineva pe un tool special pentru anunțurile de imobiliare. Cu atât mai mult pe cele din România.

În primul rând pentru că scraping-ul îl faci în funcție de tipul și structura documentului accesat (HTML, în cazul ăsta). Asta înseamnă că nu există un tool special pentru site-urile de imobiliare, ci pentru toate site-urile. Deci, te poate ajuta orice tool de web scraping. Ai putea să te concentrezi doar pe limbajul de programare în care a fost creat, cu care îți e ție mai confortabil să umbli.

Oricum, scraping-ul era la modă acum ceva ani de zile, pe vremea când documentele HTML erau generate și afișate direct. Ori, în ultima vreme site-urile (să le spunem moderne) folosesc ajax, iar conținutul real al anunțurilor (datele anunțurilor) sunt extrase printr-unul sau mai multe request-uri separate (poate chiar folosind un API intern). Asta înseamnă că o soluție mai bună, pe care nu știu dacă o mai poți numi scraping, ar fi ca tool-ul să acceseze exact acele resurse (vorbim probabil de fișiere/date json/xml, care ar putea fi parsate/procesate mult mai ușor).

Off-topic:

În altă ordine de idei, eu, dacă aș avea un site de imobiliare și orice alt tip de site, aș face tot posibilul să-ți dau calculele peste cap. Există ceva soluții pentru a preveni extragerea sau preluarea corectă a datelor din site-urile online și le-aș aplica pe toate. Până la urmă, e vorba de utilizatorii mei pe care i-aș numi “clienți” chiar și dacă nu plătesc pentru anunțurile adăugate. E vorba de datele lor postate și de faptul că ar trebui să fie conștienți de locurile în care anunțurile lor au fost publicate. Ori, permițând altora să extragă datele așa cum vor, e ca și cum nu m-ar interesa de anunțuri, respectiv de clienții mei. Nu aș accepta extragerea corectă a datelor nici măcar pentru uz personal pentru că, ce crezi, nu am încredere în modul în care vei manipula datele.

Doar pentru că oarecum nu e ilegal să faci scraping, rămâne totuși o chestiune imorală. Imaginează-ți că postezi un anunț și dintr-o greșeală faci paste la un conținut ceva mai privat. Iar până să-ți dai seama de asta, datele au fost extrase de alții și au ajuns să fie împrăștiate pe tot internetul. Nu e nimic amuzant aici pentru că uneori e foarte greu să te ia cu toții în seamă când vine vorba de “șterge-mi datele”. Nu iei în serios treaba asta pentru că probabil nu te-ai confruntat niciodată cu situația asta sau nu te-a interesat foarte mult de datele pe care le postezi. S-ar putea la un moment dat să-ți schimbi părerea, să vezi lucrurile cu alți ochi.

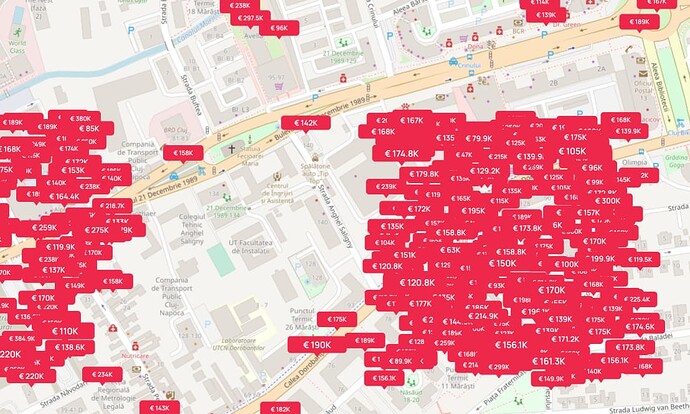

În sfârșit. Doar ca fapt divers, mă uit frecvent pe site-urile de imobiliare și chiar m-am gândit de câteva ori să-mi fac un script care să-mi extragă anunțurile care mă interesează în mod expres, în funcție de zone (pe baza coordonatelor), a anumitor filtre inexistente în site-uri, sau chiar pentru a nu mai vedea anunțurile înșelătoare pe care pare că le-ai observat și tu.

Deci, fără să fiu ipocrit spun mai degrabă că dacă intenționezi să faci scraping, ar trebui să ai grijă de date și să nu le folosești cu scopul de a le publica în alte părți. Așa ar fi ideal.

Încă o dată. Toate te pot ajuta: web scraping tools - Google Zoeken